探索发现 · 交大智慧

探索发现 · 交大智慧

上海交大人工智能学院智慧医疗团队提出文本驱动的3D医学图像分割基础模型

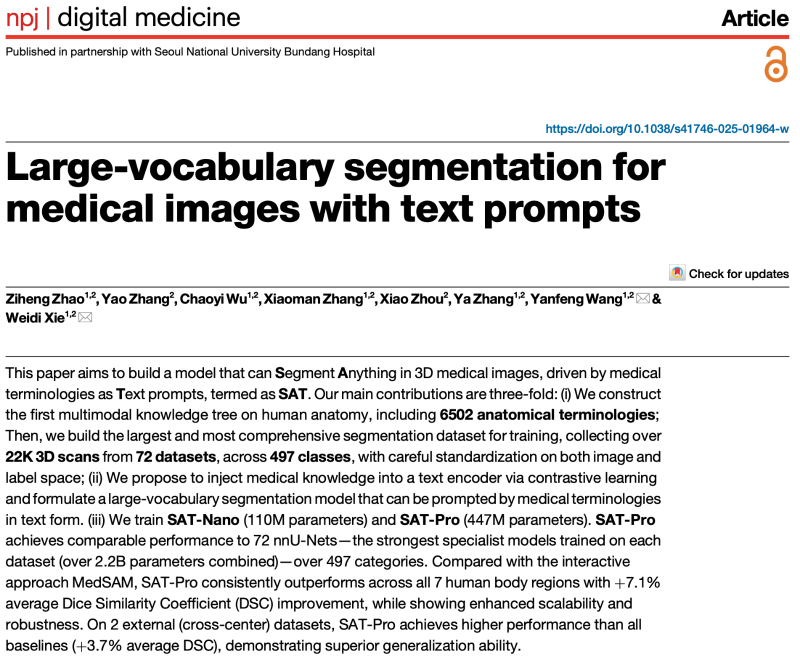

近日,npj Digital Medicine(中科院一区Top,5年影响因子约16.6)发表了上海交通大学人工智能学院智慧医疗团队的最新论文《Large-vocabulary segmentation for medical images with text prompts》。研究团队在该论文中提出了首个引入多模态解剖学知识、以文本提示驱动的3D医学分割基础模型SAT(Segment Anything in radiology scans, driven by Text prompts),并在72个数据集组成的大规模验证集上验证了其有效性与通用性。该工作已成为CVPR 2025 BiomedSegFM挑战赛的官方baseline之一。

医学图像分割在诊断、手术规划与疾病监测等任务中至关重要,但传统方法依赖逐任务训练“专用模型”, 缺乏跨部位、跨模态的通用性。同时,随着大语言模型在医疗领域的发展,亟需一种可以连接语言和定位能力的医学分割工具。为了克服这些挑战,研究团队提出了第一个引入解剖学知识增强,使用医学术语作为文本提示的3D医疗图像分割基础模型,名为SAT(Segment Anything in radiology scans, driven by Text prompts)。

图 1:SAT与现有专用模型(如nnU-Net)、交互式模型(如MedSAM)的范式差异。

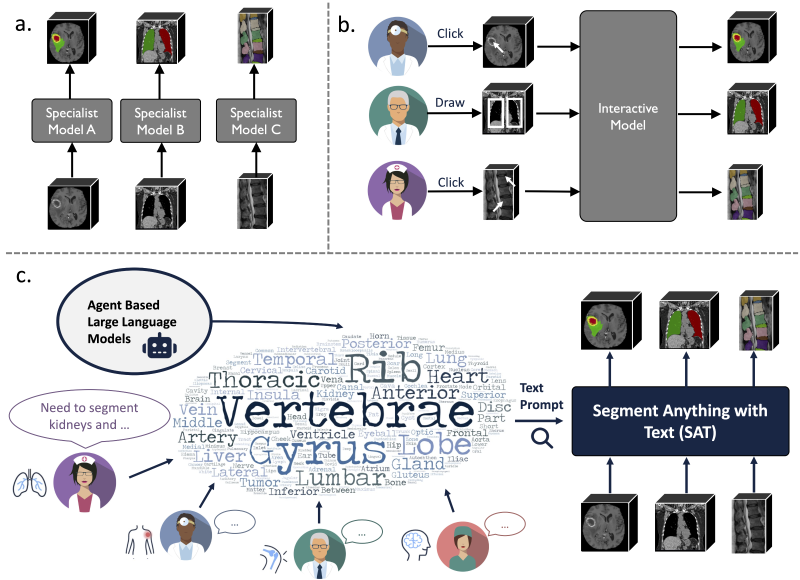

在数据层面,研究团队首先基于UMLS等多个来源,构建了领域内首个覆盖6K+人体解剖学概念的多模态知识图谱。该图谱包含概念的详细文本描述,概念之间的多种语义关系,以及部分视觉样例与分割标注。研究团队同时整合72个公开数据集,构建了大规模3D医学图像分割数据集SAT-DS,共计22186例3D图像与302033个分割标注,覆盖CT、MR与PET三种模态,人体8个主要部位的497个分割目标。

图 2:作为领域内最大规模的3D医学图像分割数据集合之一,SAT-DS涵盖了人体8个主要区域共497个分割类别。

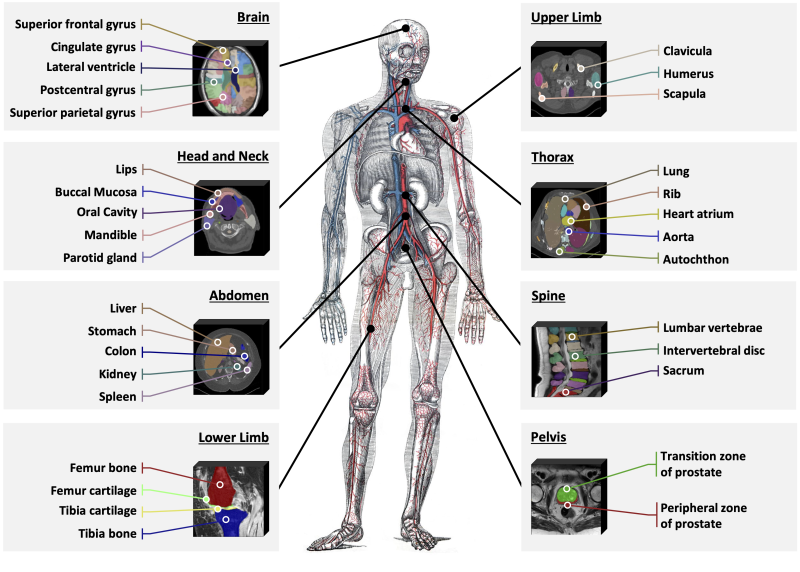

在方法层面,研究团队提出了文本提示驱动的分割模型框架,采用“知识注入+分割训练”的两阶段流程:首先通过对比学习将6K+解剖学概念的多模态知识注入文本编码器,获得更准确、与视觉空间对齐的概念表征;随后以文本编码作为提示,结合3D图像的视觉特征解码生成分割预测。

图 3:SAT的构建分为知识注入和分割训练两步。

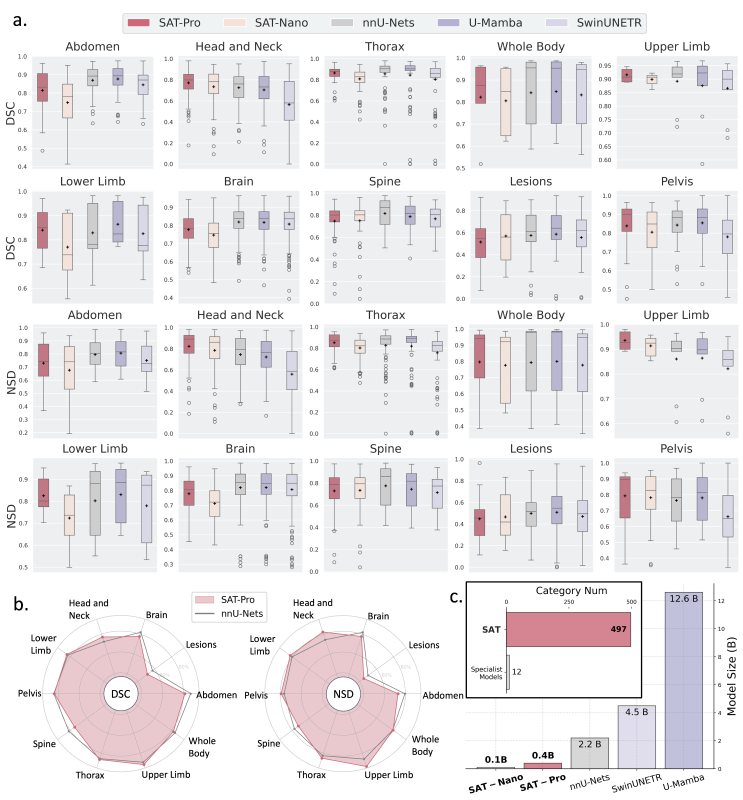

研究团队基于SAT-DS训练了SAT-Pro(447M)与SAT-Nano(110M)。在497类整体结果上,与在每个数据集上单独训练的72个nnU-Net相比,SAT-Pro的整体表现相当,但参数规模减少80%以上,显著降低了使用和部署成本;与交互式分割模型MedSAM相比,SAT-Pro在器官分割上取得显著优势,且可凭借文本提示实现全自动分割;与同时期工作BiomedParse(最早公开于2024年5月)相比,SAT-Pro在总体性能上明显领先,并支持更大规模的分割类别;研究团队同时开展了外部验证,验证了SAT在跨数据集场景下的泛化性。更多实验细节可参见论文。

图 4:SAT-Pro、SAT-Nano与专用模型nnU-Nets、U-Mamba、SwinUNETR的域内测试对比。

作为首个基于文本提示的3D医疗图像分割基础模型,SAT的价值体现在许多方面:

-SAT构建了高效灵活的分割基础模型,仅用单一模型即可在多种任务上媲美专用模型,大幅降低参数量和使用成本。

-SAT实现了基于文本提示的全自动分割,避免了交互式模型如MedSAM对人工圈画的依赖。

-研究证实了分割任务中的Scaling Law依然有效,扩大基础模型的参数量可以显著提升内外部验证集上的性能。

-研究证实了领域知识增强可有效提升分割模型的性能,尤其是在长尾类别上。

-SAT可作为大语言模型的代理工具,通过文本无缝集成分割与定位能力,推动通用医疗智能发展。

该论文由上海交通大学人工智能学院智慧医疗团队完成,第一作者为上海交通大学博士生赵子恒,共同通讯作者为上海交通大学人工智能学院王延峰教授和谢伟迪副教授。研究得到了科技创新2030“新一代人工智能(2030)”重大项目2022ZD0160702支持。

本文中所有的代码、模型和数据均已开源。

代码链接:https://github.com/zhaoziheng/SAT/

论文链接:https://www.nature.com/articles/s41746-025-01964-w

数据链接:https://github.com/zhaoziheng/SAT-DS/