探索发现 · 交大智慧

探索发现 · 交大智慧

上海交大人工智能学院智慧医疗团队在开源大语言模型的临床任务测评与对齐研究中取得新进展

近日,数字医学顶尖期刊npj Digital Medicine(Nature子刊,中科院一区Top,5年影响因子:15.2)发表了上海交通大学人工智能学院智慧医疗团队联合中国移动研究团队的最新论文《Towards Evaluating and Building Versatile Large Language Models for Medicine》。该论文介绍了联合团队提出的新医学文本测评数据MedS-Bench。MedS-Bench大规模整合了现有的异构开源医学文本评估任务,涵盖11个医学文本任务的主要类别,并对9种大语言模型的性能进行了评估,全面揭示了这些模型在选择题准确率之外,与临床实际任务需求之间的距离。研究团队还提出了专门针对医学领域的超级指令微调数据集MedS-Ins。MedS-Ins包含了58个医学领域的500万实例和1.9万条问题指令,覆盖了122个具体的任务。实验结果表明,使用MedS-Ins微调的MMedIns-Llama 3模型在多项任务上的性能有了显著提升,这一发现证实了进行更为全面的临床任务指令微调的重要性。

目前大型语言模型(LLM)在众多语言处理任务中取得了令人瞩目的成就,尤其在医学领域,LLM在医学考试和临床文本摘要等任务中展现出了媲美专家的表现。然而,在选择题和实际应用中,LLM的评价呈现出明显的两极分化,其在临床实践中的应用仍然面临诸多挑战,比如理解ICD编码的重要性和准确解读电子健康记录(EHR)数据等。这主要是因为医学场景的严肃性和对高标准的要求,而现有的基于选择题的医学评估数据并不足以全面反映大型语言模型在真实临床环境中的表现。

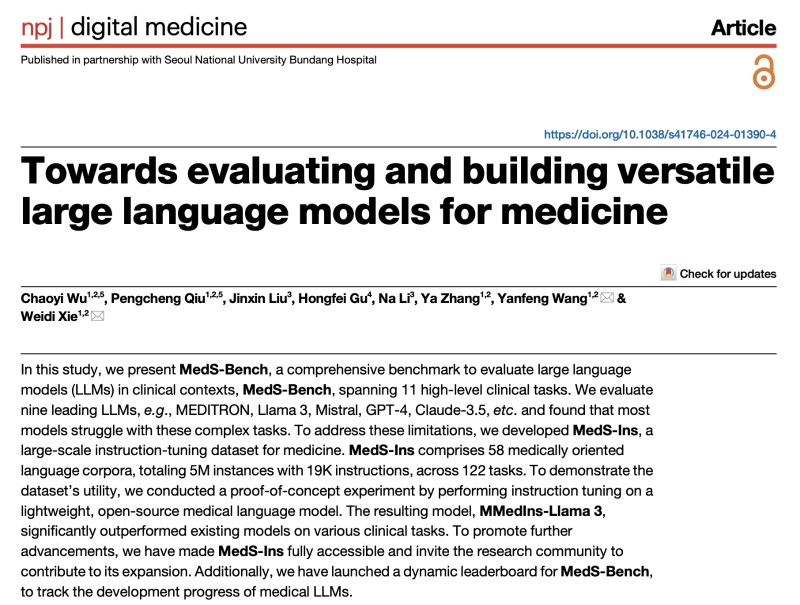

图 1 :MedS-Bench数据集统计,全面覆盖了11个任务大类,包含28个数据源以及52个任务

为了应对医疗领域中的挑战,研究团队精心设计并推出了MedS-Bench(“S”代表“Super”),一个全面超越传统多项选择题的评估基准,如图1所示。MedS-Bench涵盖了11个关键的医学任务领域,如实体识别、报告摘要撰写、诊断推理、治疗建议制定等。该评估工具旨在协助医疗专业人员更深入地理解各类大型语言模型在多样化临床任务中的实际表现。研究团队在MedS-Bench数据集上对9种主流的大型语言模型进行了深入评估,这些模型包括MEDITRON、Mistral、InternLM 2、Llama 3、Qwen2、Baichuan 2、Med42-v2、GPT-4以及Claude-3.5(注:鉴于研究团队在7-8B参数规模上进行了概念性验证,所有参与比较的“开源模型”均基于相似的中等参数规模)。评估结果显示,尽管这些大型语言模型在选择题评估中表现突出,但在处理复杂的实际临床任务时仍存在显著的局限性。

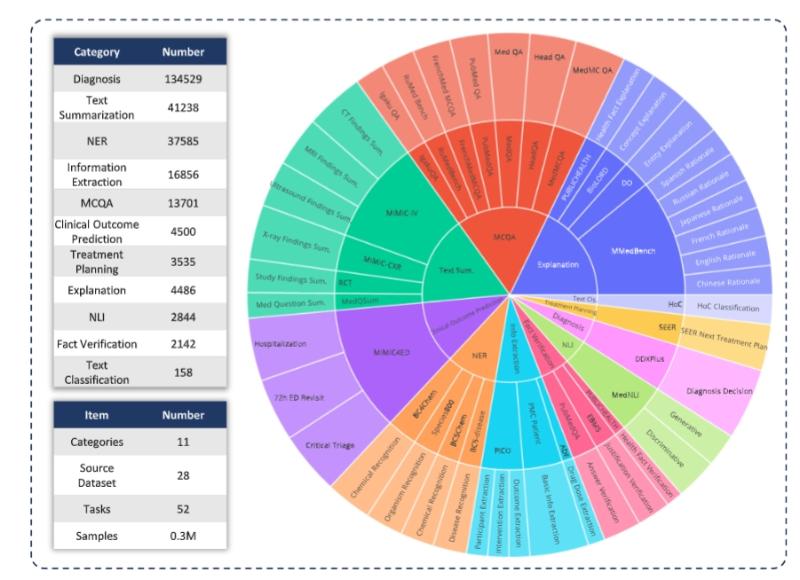

图 2:子图a、子图b、子图c展示了MedS-Ins的构建流程子图d进一步展现了MedS-Ins上数据的分布情况

为了增强开源医学模型在临床任务中的表现,研究人员借鉴了自然语言处理领域中Super-Instruction的成功经验,开发了一个全面且细致的医学任务指令微调数据集,如图2所示。该数据集汇集了58个开源生物医学数据集,覆盖五大文本来源(考试材料、学术论文、医学知识库、日常对话),最终收集了近500万条实例,包含19,000条多样化的医学指令,覆盖了122个临床任务。通过对8B参数的大型语言模型进行概念验证实验,研究人员证实了经过全面医学任务指令微调后,开源的大型语言模型能够更好地满足临床需求,并在多个临床任务上的表现与闭源模型相媲美。

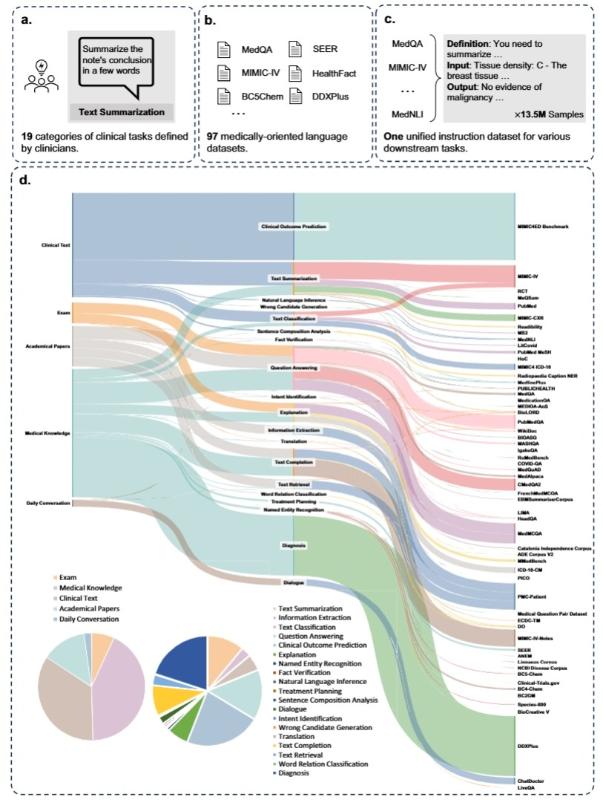

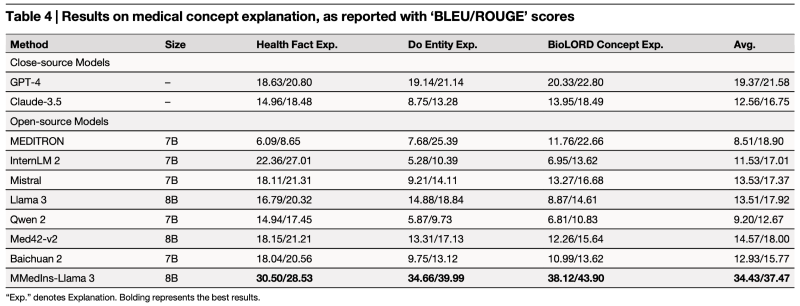

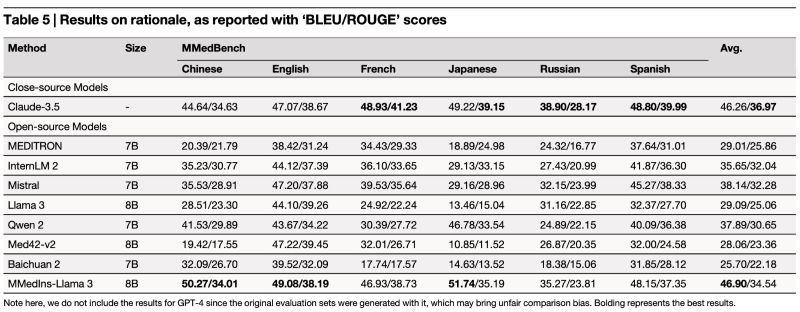

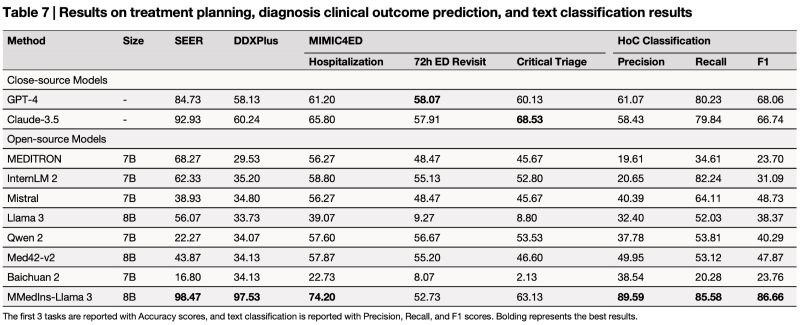

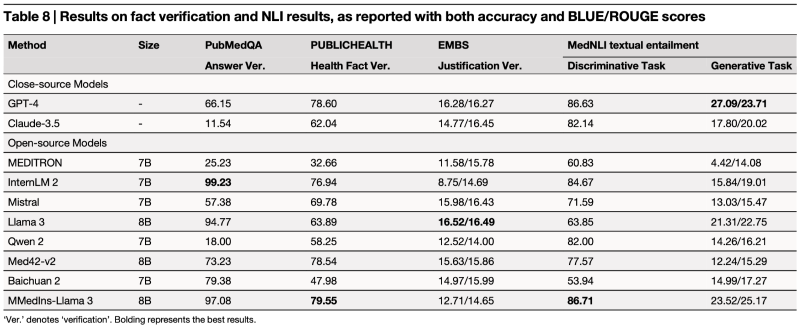

具体而言,研究团队在本文中进行了大量测评与对比,涵盖11个医学文本任务的主要类别以及9种大语言模型,原论文对每一个任务都进行了细致的讨论。经过综合分析研究结果,研究人员观察到不同模型在多样的医学临床任务中展现出了各异的性能,但总的来说,闭源模型的表现较为突出。然而,即便它们的表现相对优越,与实际临床应用所需的性能标准相比,仍存在明显的不足。而论文提出的MMedIns-Llama 3则证明了经过领域全面监督微调,模型可以更好地适配临床应用场景。

图3:在医学选择题回答、文本总结任务上的性能对比

图4:在医学信息提取、解释(进一步拆解为概念解释与回答归因两个子类)任务上的性能对比

图5:在医学实体抽取(NER)、治疗规划、诊断、临床结局预测、文本分类、事实验证和文本蕴含任务上的性能对比

最后,本文的关键贡献可以归纳为三点:

1.研究人员构建了一个全面的评估基准——MedS-Bench。医疗大语言模型的发展在很大程度上依赖于专注于多项选择题回答(MCQA)的基准。然而,这种单一的评估框架可能会忽视模型在各种临床场景中所需的更广泛能力。在本研究中,研究人员引入了MedS-Bench,该综合基准旨在评估封闭源和开源大语言模型在多样化临床任务中的表现,包括需要模型内部知识或基于上下文推理的任务。测评结果显示,尽管现有的模型在MCQA基准上表现异常出色,但在与实际临床实践对齐方面存在困难,尤其是在治疗计划和解释等任务上。这一发现强调了进一步开发更适应广泛临床和医疗场景的医疗大语言模型的必要性。

2.研究人员引入了一个新的综合指令调整数据集——MedS-Ins。MedS-Ins是一个全新的医疗指令调整数据集,通过广泛从现有的医学自然语言处理数据集中获取数据,并使用半自动化提示策略将这些样本转换为统一格式。以往的工作主要集中在从日常对话、考试或学术论文中构建问答对,常常忽视了来自真实临床实践生成的文本。相比之下,MedS-Ins整合了更广泛的医学文本来源,涵盖了五个主要文本领域和19个任务类别。这种多样化的数据组成对于大语言模型在临床实践的应用至关重要。

3.研究人员提出了一个强大的医疗大语言模型——MMedIns-Llama 3。在模型开发方面,研究团队展示了通过在MedS-Ins上进行针对性的指令微调,可以显著提升开源医疗大型语言模型与临床需求的契合度。MMedIns-Llama 3作为一个概念验证模型,虽然架构规模中等,仅拥有8B参数,却展现了对各类临床任务的深刻洞察力。实验结果表明,MMedIns-Llama 3在一系列涵盖不同文本来源的医疗基准测试中,超越了现有的大型语言模型,包括GPT-4和Claude-3.5。

该论文由上海交通大学智慧医疗团队以及中国移动公司的研究团队联合完成,共同第一作者为上海交通大学博士生吴超逸,邱芃铖,共同通讯作者为上海交通大学人工智能学院王延峰教授和谢伟迪副教授。该研究得到了中国国家重点研发计划2022ZD0160702的支持。