探索发现 · 交大智慧

探索发现 · 交大智慧

上海交大马利庄教授团队在CVPR 2022发表14篇高水平论文

近日,计算机视觉顶级会议CVPR 2022公布录用名单,上海交通大学电子信息与电气工程学院计算机系马利庄教授团队表现不凡,共有14篇论文录用。马利庄教授团队主要研究方向包括数字媒体、计算机视觉、机器智能及虚拟现实等。团队由马利庄教授领导,成员包括卢策吾教授、盛斌教授和易冉助理教授等。

CVPR(计算机视觉与模式识别会议,IEEE Conference on Computer Vision and Pattern Recognition)是计算机视觉和模式识别领域的顶级会议,中国计算机学会推荐的A类会议。根据谷歌学术公布的2021年最新学术期刊和会议影响力排名,CVPR在所有学术刊物中位居第4,仅次于《Nature》、《NEJM》和《Science》。

下面对录用论文的研究内容和方法进行简单的介绍:

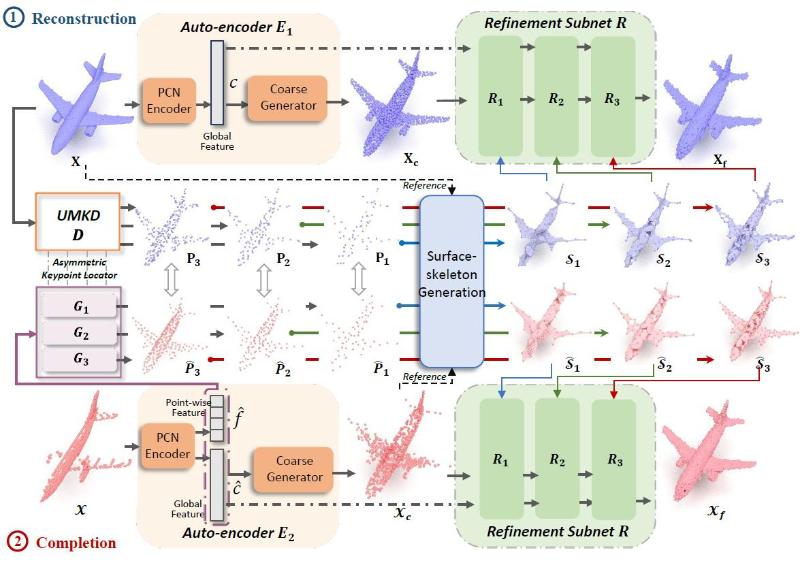

论文1: LAKe-Net: Topology-Aware Point Cloud Completionby Localizing Aligned Keypoints

作者: 唐俊姝、龚致君、易冉、谢源、马利庄

工作简介:点云补全旨在通过局部观察到的点云形状来补全几何和拓扑形状。然而,现有方法无法应对一些原始形状的某些拓扑缺失。团队提出一种新颖的拓扑感知点云补全模型,通过定位对齐的关键点,应用“关键点-骨架-形状”这一补全方式。方法包括三个步骤:对齐关键点定位,表面骨架生成和形状细化。团队提出了无监督的多尺度关键点检测器并从理论上证明了捕获到的子类别内对象的关键点的有序性。团队基于几何先验和关键点的提出了一种名为表面骨架的新型结构,以从关键点捕获信息来表示完整拓扑信息,并更好地恢复局部细节。团队设计了细化模块,用多尺度表面骨架来协助补全过程。实验结果表明,团队的方法在点云补全上达到了最先进的性能。

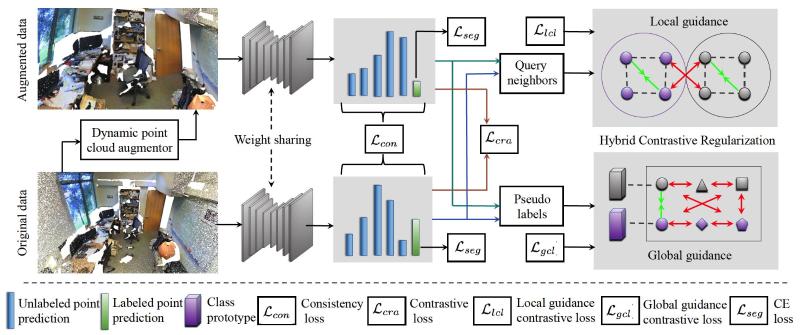

论文2: HybridCR: Weakly-Supervised 3D Point Cloud Semantic Segmentation via Hybrid Contrastive Regularization

作者:李梦甜、谢源、沈云航、柯博、谯睿智、任博、林绍辉、马利庄

工作简介:为了解决大规模3D点云语义分割中标注成本过于高昂问题,团队提出了一种新颖的混合对比正则化(HybridCR)弱监督学习框架。该框架显式地考虑了3D点云场景中局部相邻点之间的语义相似性,并有效地利用了大规模输入下的全局3D类别原型属性。为进一步提升框架的性能和泛化性,该框架设计了一个全新的动态点云增强器,为输入的点云数据生成多样的增强样本。在训练过程中,通过结合混合对比正则化、点级别一致性正则以及有标签样本的监督损失,采用端对端训练方式,能有效联合优化动态点云增强器和网络模型的参数。大量实验结果表明,HybridCR在大规模3D点云室内和室外数据集上(即 S3DIS、ScanNet-V2、Semantic3D 和 SemanticKITTI)同时达到最好性能。

论文3: Rethinking Efficient Lane Detection via Curve Modeling

作者:冯正阳、郭绍华、谭鑫、许可、汪旻、马利庄

工作简介:本文提出了一种基于参数曲线的图像车道线检测方法。与SOTA方法(语义分割或点目标检测)不同,曲线可以自然地表达车道线,而不需要启发性的大量anchor或从模型输出解码。为了应对现存曲线方法难优化的问题,团队转而使用简洁、稳定且具有足够自由度的贝塞尔曲线。另外,团队基于可变卷积提出特征翻转融合策略,从而利用驾驶场景的对称性。提出的方法在知名的LLAMAS 数据集上达到了SOTA 。在CULane和TuSimple数据集也有不错的性能,同时保持着低延迟( > 150 FPS),模型小 ( < 10M参数)的特点。团队的方法为业界提供了一个新的思路和基线。本文的代码和一个面向自动驾驶感知任务的框架 PytorchAutoDrive 已在 https://github.com/voldemortX/pytorch-auto-drive 开源。

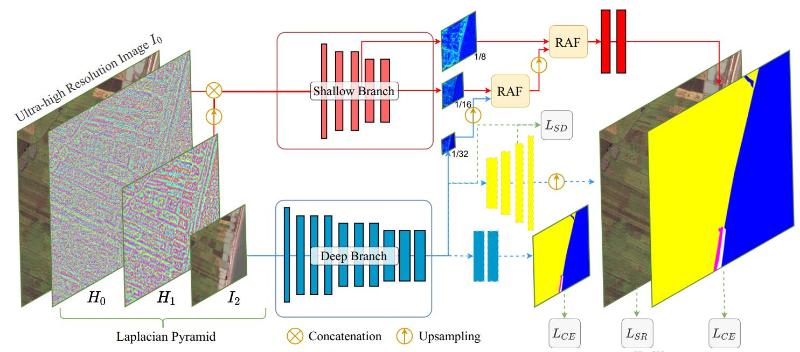

论文4:ISDNet: Integrating Shallow and Deep Networks for Efficient Ultra-high Resolution Segmentation

作者:郭绍华,刘亮,甘振业,王亚彪,章吴昊,汪铖杰,江冠楠,张伟,易冉,马利庄,许可

工作简介:为了解决超高分辨率图像推理速度慢的问题,团队提出一个新的方法--ISDNet。团队的方法集成了深浅层网络来处理不同分辨率的图像,其中深层网络从低分辨率图像提取语义信息,浅层网络从高分辨率图像提取空间信息,通过这样的方式可以明显加快推理速度。同时,为了保证分割精度,团队提出了新的感知特征融合模块,这确保了方法高性能和鲁棒性。团队在 Deepglobe、Inria Aeril 和 Cityscapes 数据集上进行的大量实验表明,结果表明性能始终优于最先进的技术。在DeepGlobe数据集上,它以 27.70 FPS 的速度达到 73.30 mIoU,比最近的竞争对手FCtL快了172倍。

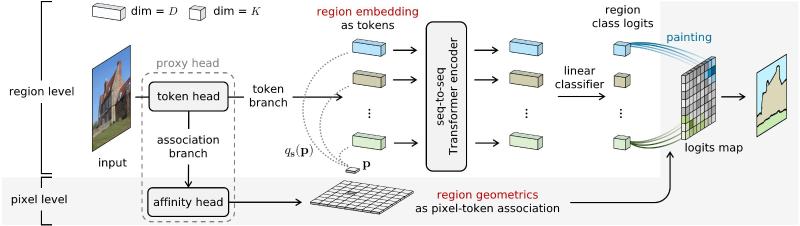

论文5:Semantic Segmentation by Early Region Proxy

作者:张熠帆,庞博,卢策吾

工作简介:本文从一个全新视角思考了语义分割问题。从传统的超像素分割中得到启发,团队将图像视为若干语义单一、可学习的小区域(regions)的密铺。不同于dense prediction(即在规则网格上做逐像素预测)的传统思路,团队利用Transformer模型,以seq2seq的方式对上述区域进行分类,从而在不需要decoder的情况下完成分割。模型构建于ViT之上,仅用极少的额外参数/计算量(~0.5%)即可远超baseline并取得SOTA性能。代码和模型将于近期开源。

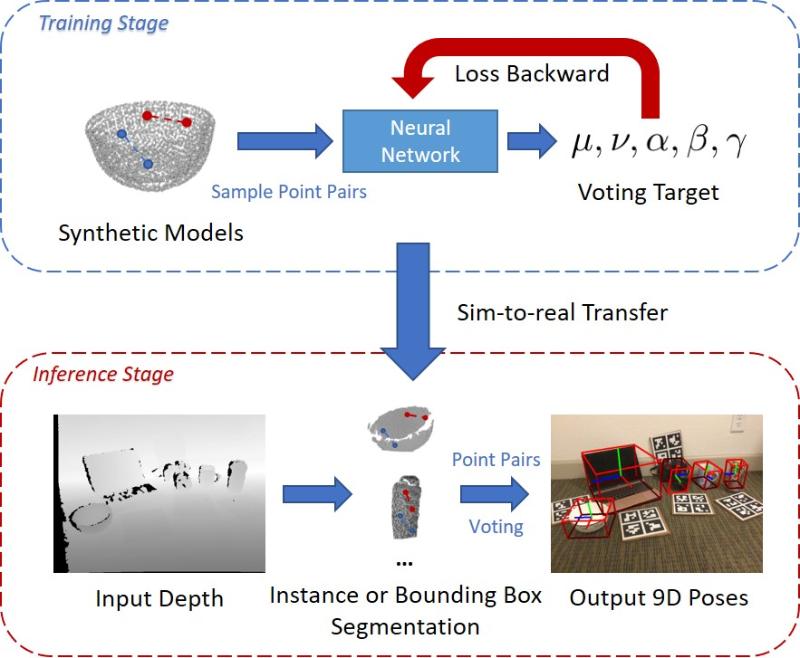

论文6:CPPF: Towards Robust Category-Level 9D Pose Estimation in the Wild

作者:尤洋,时若曦,王伟明,卢策吾

代码地址:https://github.com/qq456cvb/CPPF

工作简介:本文主要研究单个 RGB-D 帧在未知场景下的类别级 9D 姿态估计的问题。之前的工作大多依赖真实世界 9D 姿态的标注数据,这很费力并且也无法推广到看不见的场景。团队从传统的点对特征 (PPF) 中汲取灵感,设计了一种新颖的类别级 PPF (CPPF) 投票方法,以在未知场景中实现准确、稳健、的 9D 姿态估计。为了获得稳健的姿态估计,团队在物体上采样许多点对,对于每一对,模型预测物体中心、方向和尺度上必要的刚性变换不变投票。模型仅在合成点云上训练,并直接迁移到真实场景。标准基准的结果表明,该方法与使用真实世界训练数据的水平相当,同时对噪声具有很好的鲁棒性。

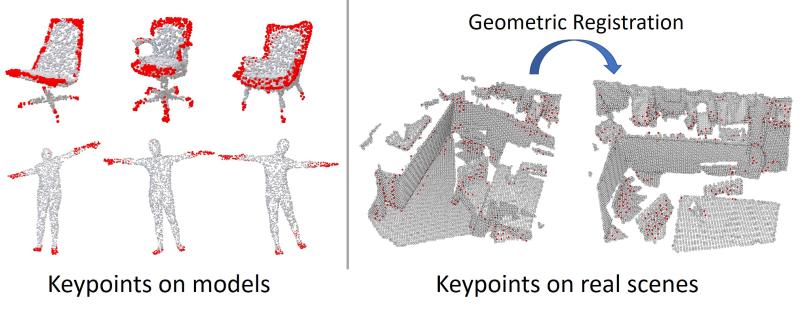

论文7:UKPGAN: A General Self-Supervised Keypoint Detector

作者:尤洋,刘文海,迮炎杰,李永露,王伟明,卢策吾

代码地址:https://github.com/qq456cvb/UKPGAN

工作简介:关键点检测对于物体配准和场景对齐非常重要。在这项工作中,团队将关键点检测视为一种信息压缩,并强制模型通过重构提取物体的关键点。基于此,团队提出 UKPGAN,这是一种通用的 自监督 3D 关键点检测器。本文提出了两个模块:基于GAN的关键点稀疏控制和显着信息蒸馏模块来定位那些重要的关键点。大量实验表明,这些关键点与人类标注的关键点标签很好地对齐,并且可以应用于非刚性变形下的 SMPL 人体。此外,团队在ShapeNet合成物体上训练的关键点检测器可以很好地推广到现实世界的场景,与现成的三维点描述符结合使用时可以进一步改进几何配准的结果。可重复性实验表明,团队的模型在刚性和非刚性变换下都是非常稳定的。

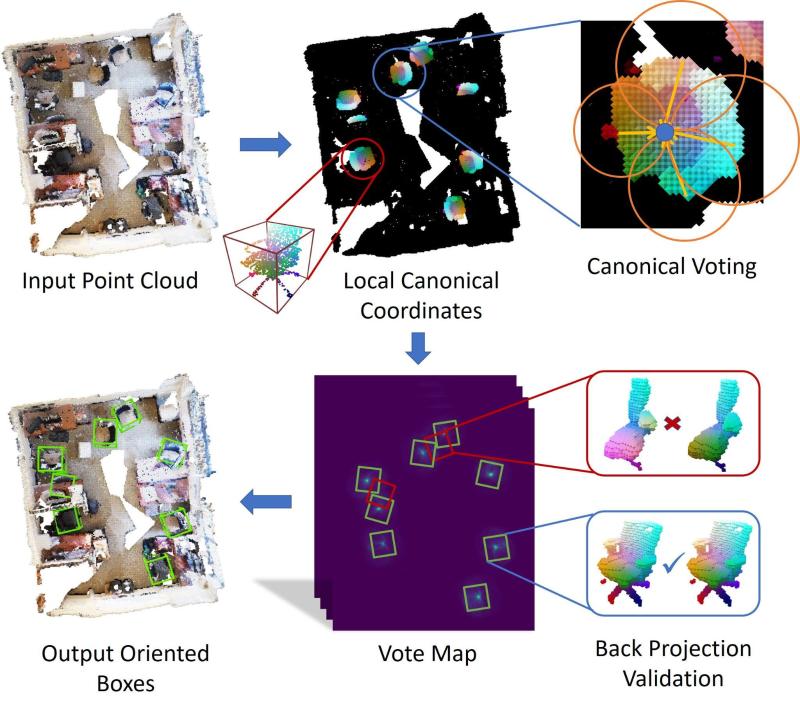

论文8:Canonical Voting: Towards Robust Oriented Bounding Box Detection in 3D Scenes

作者:尤洋,叶泽林,楼雨京,李成坤,李永露,马利庄,王伟明,卢策吾

代码地址:https://github.com/qq456cvb/CanonicalVoting

工作简介:由于传感器和点云深度学习方法的进步,3D物体检测成为理解三维物体的一个重要步骤。当前最先进的方法(如 VoteNet)使用附加的多层感知器网络直接向物体中心和包围盒方向回归偏移量。由于三维旋转分类本身是一个很困难的问题,它们的偏移和方向预测都不准确。在本文,团队将直接偏移量分解为局部规一坐标 (LCC)、包围框尺度和包围框方向。团队仅回归 LCC 和包围框尺度,而包围框方向由逐点的投票算法生成。最后,一个基于 LCC 的反投影检查算法迭代地从生成的投票图中找出包围框,并消除误报。团队的模型在三个标准的真实世界基准测试中实现了最先进的性能:ScanNet、SceneNN 和 SUN RGB-D。

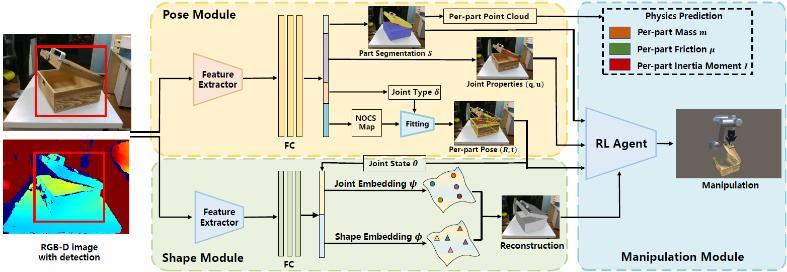

论文9: AKB-48: A Real-World Articulated Object Knowledge Base

作者: 刘浏、徐文强、付昊源、钱苏澄、韩杨、卢策吾

工作简介:本文针对真实世界关节体视觉感知和操作问题,创新性地提出了一个大规模真实世界关节体知识引擎AKB-48,其中包含了48类常见关节物体类别,共计2037个关节体和其对应的知识,相比于现在的真实世界数据集,团队的知识库规模有两个数量级的提升。为了表示视觉感知和操作任务所需要的关节体知识,本文为每个物体建立了一种关节体知识图(ArtiKG),包含物体的外形、结构、语义和物理信息,这些物体知识由团队所构建的快速关节体入库流程FArM采集并标注,平均入库时间在15分钟以内。最终基于该知识库,本文提出了全新的关节体从感知到操作的深度学习框架AKBNet,在类别级关节体的姿态估计、三维重建和操作任务提供了很强的baseline。数据和代码将在https://liuliu66.github.io/articulationobjects开源。

论文10:Human Trajectory Prediction with Momentary Observation

作者:孙健华,李宇轩,柴亮,方浩树,李永露,卢策吾

工作简介:行人轨迹预测旨在根据历史状态分析人类的未来运动,这是许多无人系统中一个关键步骤。考虑到实际应用中不可避免的因素,如跟踪丢失和突发事件,不可能在任何时候都获得足够长的观测数据来保证高精度预测。本文提出并研究一种极端情况,取名为 "瞬间轨迹预测 ",将观察历史从长序列减少到只有两帧,其中一帧以抽取场景信息,两帧共同提取行人的速度。同时,团队进一步提出了一个一体化的特征提取器和一种预训练机制,它们可以广泛应用在现有预测框架上,以更有效地捕捉瞬时观察中的信息并大幅提高其在这种极端情况下的预测精度。团队希望对这一任务的研究能够帮助自动驾驶和机器人社区研发精确预测,迅速响应,更加鲁棒的自动化系统。

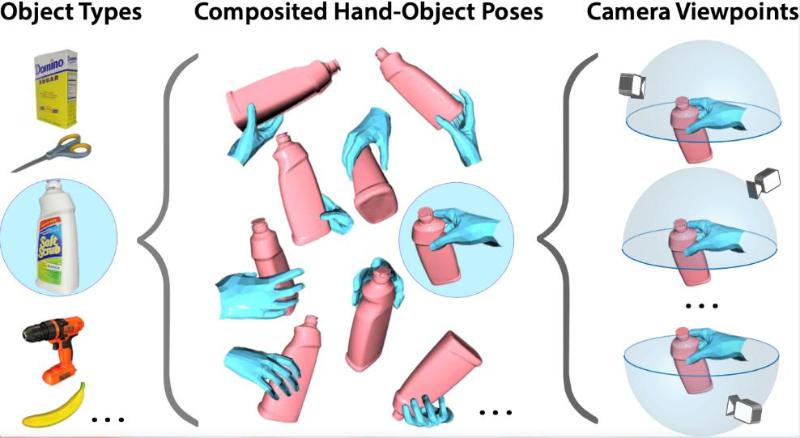

论文11:ArtiBoost: Boosting Articulated 3D Hand-Object Pose Estimation via Online Exploration and Synthesis

作者:杨理欣,李恺林,詹欣宇,吕峻,徐文强,李杰锋, 卢策吾

代码地址:https://github.com/lixiny/ArtiBoost

工作简介:手物姿态估计(HOPE)任务在当前机器人模仿学习,或者说元宇宙的基础建设上有着不可或缺的作用。针对HOPE的数据集需要在手的姿态、物体类别与姿态、观测视角三个方面提高多样性。然而,大多数现实世界的数据集缺乏这种多样性,但合成数据集可轻松确保多样性。 “如何构造合理的手物交互姿态”以及 “如何从大样本合成数据集中高效学习” 是该方法的难点。本文给多关节式的手(+物体)姿态估计问题提供了一个新且有效的的解决方案: ArtiBoost。它基于一种“手-物-视点”空间覆盖这三类多样性,并通过重加权采样策略增加当前难以区分的训练样本。在训练过程中,ArtiBoost 交替进行数据探索和合成,并将这些数据混合到真实的源数据中。该方法只需修改数据集载入方法,就能做到与现有CNN网络快速适配,即插即用,能快速将现有SOTA算法应用到新的的手、手+物的数据集与应用场景。

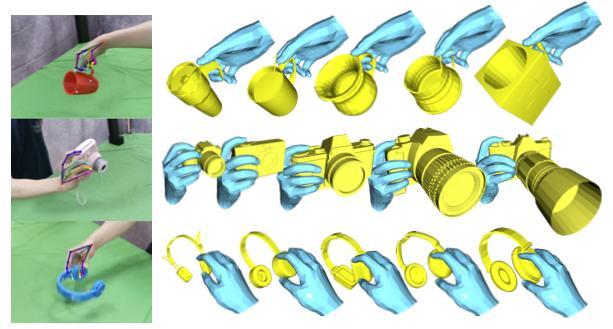

论文12:OakInk: A Large-scale Knowledge Repository for Understanding Hand-Object Interaction

作者:杨理欣,李恺林,詹欣宇, 吴非, 徐安然, 刘浏, 卢策吾

代码地址:https://oakink.net

工作简介:学习人类如何操作物体需要机器从理解物体的功能性和基于功能性学习人类的交互/操作行为两个角度获取知识。这两个知识至关重要,但当前数据集通常缺乏对它们的全面认识。本文提出了一个全新的大型知识库 Oakink,旨在通过视觉信息对手物交互行为进行认知与理解。首先收集了1800个常见的家居物品并标注它们的功能性,构成了第一个知识库:Oak (Object Affordance Knowledge)。基于物体的功能性,团队在Oak 中的100个物体上,记录了人类与其的交互行为。另外,团队提出一种新的映射算法Tink,将这100 个物体上的交互映射到它们的虚拟对象上。这些被采集的和被映射的手物交互样本构成第二个知识库:Ink (Interaction Knowledge)。统计下来,OakInk 包含 50,000 个手物交互案例。团队还给OakInk提出了两个应用场景:“基于意图的交互生成”和“人与人的双手交递生成”。

论文13: Learning to Anticipate Future with Dynamic Context Removal

作者: 徐昕宇、李永露、卢策吾

工作简介:本文针对视频中的动作预测问题提出了语境帧动态消除的训练方法。团队借助了课程化学习的思想提出了多阶段训练方法:开始于所有帧可见的视频动态逻辑结构学习,到带有部分额外语境帧信息提示的动作预测学习,最终实现无额外语境帧信息的预测。团队的训练方法是即插即用的,可以帮助多种通用的预测型神经网络提升性能。实验方面,团队在四个通用的数据集上达到了SOTA性能,同时还保持着模型小(少于baseline一半的参数量)的优势。团队的代码和预训练模型将在近期开源。

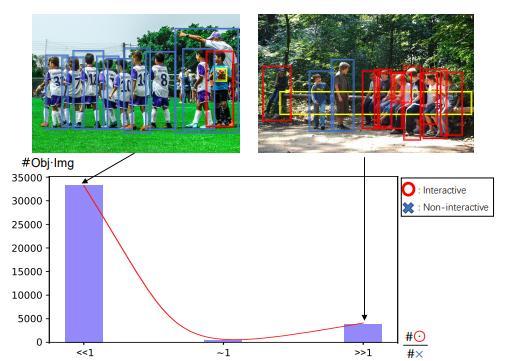

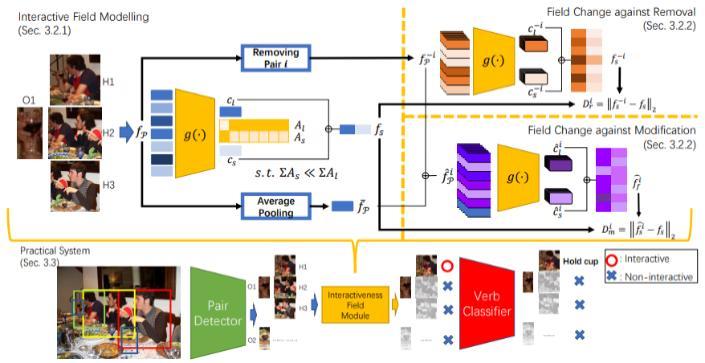

论文14: Interactiveness Field of Human-Object Interactions

作者: 刘欣鹏*,李永露*,吴小茜,戴宇榮,卢策吾,鄧智強

工作简介: 人-物交互行为检测在行为理解领域具有核心地位。尽管近期的两阶段/一阶段方法取得了不错的效果,但其中的关键步骤——对有交互的人-物对进行检测——仍然极具挑战性。本文介绍了一种此前被忽视的交互性双模先验:对于一张图片中的一个物体,在将其与人体配对之后,生成的人-物对要么主要为非交互对要么主要为交互对,其中前者的情况更加常见。在这一先验的基础之上,本文提出了交互性场这一概念。为使得学习到的场能和真实人-物交互行为的场景相适应,本文基于容量和交互性场中交互对和非交互对的区别,设计了全新的能量约束。在多个广泛应用的人-物交互行为数据集上,本文相对于此前方法取得了不错的提升。