探索发现 · 交大智慧

探索发现 · 交大智慧

人工智能《自然》子刊突破!

上海交大电子信息与电气工程学院卢策吾团队在人工智能《自然》子刊提出时空概念提取算法

引言:近期,上海交通大学电子信息与电气工程学院在《自然》机器智能杂志子刊上发表关于高维度视觉序列理解上的研究成果《Complex sequential understanding through the awareness of spatial and temporal concepts》。上海交通大学是该论文的唯一单位,也是我校第一篇入选该期刊的论文。于此同时,该团队将该论文代码与近两年在视频理解领域的先进成果开源为视频理解工具箱:AlphaVideo (代码链接:https://alpha-video.github.io/)。在物体跟踪任务(MOT)和行为理解(AVA单模型)上都达到最高准确率比起,比SlowFast[4]有12.6%的相对提高。

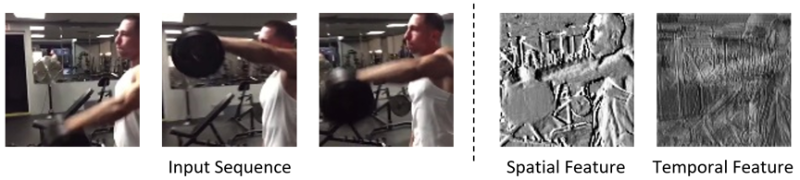

图1 动作理解任务的时空信息特征图。左:输入序列;右:空间特征更关注物体形状,时间特征更关注物体运动趋势。

人类视觉理解机理:在人类的视觉认知过程中时间和空间概念解耦。神经科学领域的研究发现在人类的记忆形成过程中,时间信息与空间上下文信息是通过两个相对独立的信息通路到达海马体以形成完整的记忆[1]。

新技能:自主学习时空概念

通过模仿人类的认知机制,本文提出了应用于高维度信息的半耦合结构模型(SCS)。 SCS自主发掘(awareness)时间-空间概念,并让他们耦合协作以理解序列信息。这种能力代表着机器学习模型自主掌握了时空的概念,这是一种更高层的智能。更进一步,时空信息概念的分离也让 “概念编辑”成为了可能。![]()

半耦合结构模型

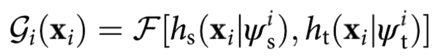

半耦合结构首先解耦时空信息(模仿人脑中的两条信息通路),并在分别处理时间和空间信息之后将二者耦合(模仿海马体):

hs(·)负责处理空间信息,ht(·)负责时间信息,F负责融合两种信息。

通过堆叠这种半耦合的元结构,我们可以构建深度模型。其中时空信息始终以先解耦再融合的模式向后流动。为了让hs和ht各司其职,研究者们将hs和ht设计为不对称的结构,同时,使用两个特殊的监督目标rs,rt来进一步约束二者关注自己的工作。研究者们进一步提出了一种训练的注意力机制。这种注意力机制控制着模型在优化过程中学习哪种信息。例如在视频信息中,模型可以优先将注意力集中在空间信息上,待空间信息有效且稳定时,逐步将模型训练的注意力转换到时间信息上。

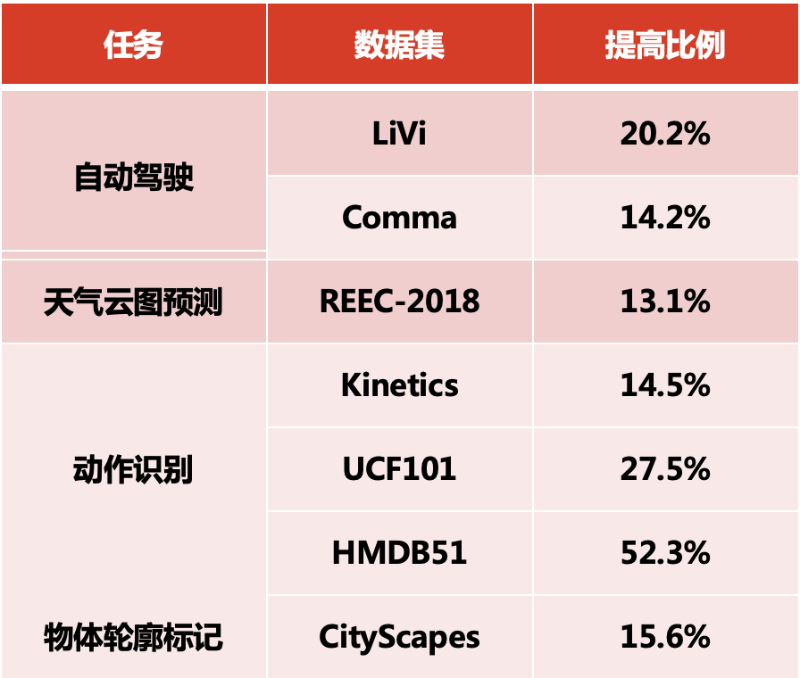

SCS的表现如何?

任务性能对比与传统LSTM比较,代码:

https://doi.org/10.5281/zenodo.3679134

SCS在视频动作分类,自动驾驶,天气预报等4个任务上的性能都超越了传统的序列模型。

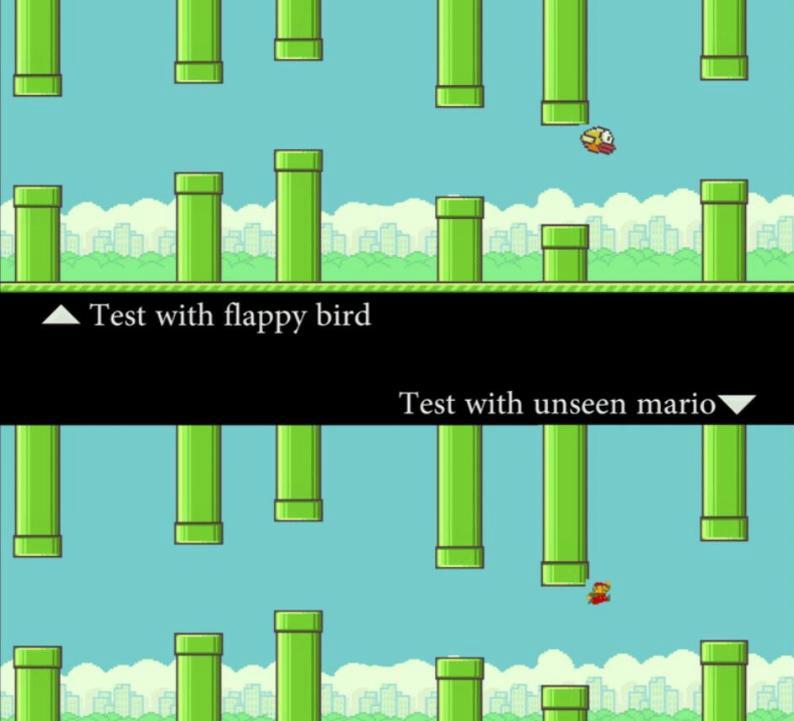

概念编辑

有了时空分离的能力,SCS将可以初步做到“概念编辑”。比如,通过编辑空间概念且保留时间概念,我们可以让一个原本用于预测狗的运动轨迹的模型做到预测猫的轨迹。这样将以比较小的代价实现模型的泛化,同时也扩宽模型的使用场景与部署难度。如图6.

图. 6 概念编辑demo。我们让计算机看Flappy Bird的视频,然后看一张静态的Mario图片(外观形象)。在这个过程中,模型并没有接触到任何mario在管道中穿梭的运动信息。通过“概念编辑”,测试时SCS也可以准确地预测mario的运动轨迹。

视频理解工具箱AlphaVideo

视频理解工具箱AlphaVideo中,除了上述SCS时空概念分解,我们也提供了单阶段端对端训练的多目标跟踪模型TubeTK和视频动作检测模型AlphAction。使用一行代码,即可调用预训好的各类模型。

AlphAction

AlphAction是面向行为理解的开源系统,基于MVIG提出的交互理解与异步训练策略[5]在AVA数据集上达到最好准确率,速度达到10帧每秒。15个开源的常见行为基本模型mAP达到约70%,接近可以商用的水平。

TubeTK

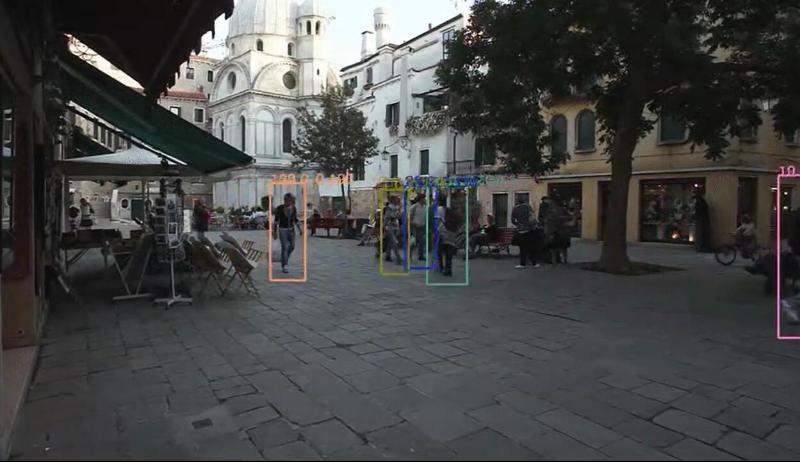

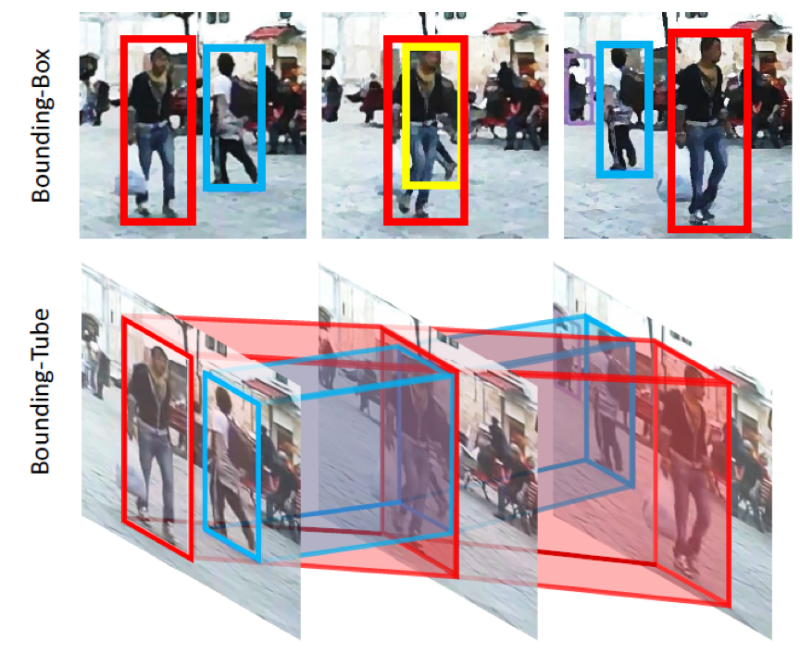

TubeTK是上海交大MVIG组提出的基于Bounding-Tube的单阶段训练模型(CVPR2020-oral),是第一个单阶段可以端对端训练的多目标跟踪模型,在MOT-16数据集上达到了66.9MOTA的精度。这是目前online模型仅在MOT训练数据下达到的最高精度[3]。

Fig. 7 TubeTK 可视化结果

Fig. 8 Bounding-Tube示意图。使用bounding-tube可以轻松跟踪到bounding-box无法检测到的被遮挡目标(图中黄色框)

参考文献

[1] Kitamura, T. etal. Entorhinal cortical ocean cells encode specific contexts and drive context-specific fear memory. Neuron 87, 1317–1331 (2015).

[2] Simonyan, K. & Zisserman, A. Two-stream convolutional networks for action recognition in videos. In Proceedings of the 27th International Conference on Neural Information Processing Systems 568–576 (ACM, 2014).

[3] https://motchallenge.net/tracker/3184&chl=5

[4] Feichtenhofer, C., Fan, H., Malik, J., & He, K. (2019). Slowfast networks for video recognition. In Proceedings of the IEEE International Conference on Computer Vision (pp. 6202-6211).

[5] Tang, J., Xia, J., Mu, X., Pang, B., & Lu, C. (2020). Asynchronous Interaction Aggregation for Action Detection. arXiv preprint arXiv:2004.07485.

作者简介:

卢策吾 上海交通大学特别研究员。在他加入交大之前,他是斯坦福大学人工智能实验室研究员。他的研究兴趣主要集中在机器人、人工智能和机器人计算机视觉。担任《科学》《自然》人工智能方向审稿人,CVPR 2020的领域主席。他还入选了MIT TR35-《麻省理工技术评论》35位个35岁以下的创新者,求是杰出青年学者(近三年唯一AI方向)。Homepage: http://mvig.sjtu.edu.cn/

庞博 上海交通大学在读博士生,上海交通大学计算机系学士。主要研究方向为计算机视觉和深度学习,尤其是视频理解算法包括动作理解,多目标跟踪,视频关键点估计等。Homepage: https://bopang1996.github.io

汤佳俊 上海交通大学在读硕士生,上海交通大学计算机系学士。主要研究方向为计算机视觉和深度学习,尤其是视频动作理解算法。