综合新闻

综合新闻

电院博士毕业生徐宇辉论文入选中国图象图形学学会博士学位论文激励计划

近日,中国图象图形学学会公布了2023年度CSIG博士学位论文激励计划的评选结果,上海交通大学电子信息与电气工程学院电子工程系博士毕业生徐宇辉的论文《卷积神经网络模型和结构优化》上榜,论文指导教师为熊红凯教授。

“中国图象图形学学会博士学位论文激励计划”为推动中国图象图形学领域的科技进步,鼓励创新性研究,促进青年人才成长而设立。2023年度共有10篇论文入选激励计划。

获奖学生简介

徐宇辉,2016年获东南大学学士学位,2021年获上海交通大学信息与通信工程博士学位,曾获CSC国家留学基金资助赴约翰霍普金斯大学进行联合培养。研究方向为神经网络压缩和Auto-ML。在人工智能顶级期刊《IEEE Transactions on Pattern Analysis and Machine Intelligence》发表论文两篇,谷歌学术引用量超过1000。

2021年徐宇辉(右)与导师熊红凯教授(左)在博士论文答辩现场合影

入选论文《卷积神经网络模型和结构优化》

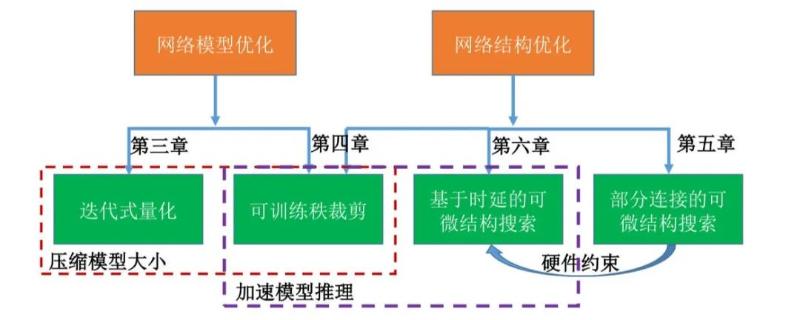

论文主体框架及各章节之间的联系

内容简介:卷积神经网络(CNN)在许多计算机视觉任务上展现出了显著的效果。现有的网络模型和结构因参数量和计算量过大的问题,很难在资源受限的设备上部署。因此对现有模型进行压缩或者利用网络结构搜索(NAS)设计更高效的结构具有重要的研究和实用意义。然而目前的模型和结构优化存在以下几个问题:现有的模型压缩算法会造成无法恢复的性能损失并且缺少理论分析。启发式NAS算法搜索成本过大;可微网络结构搜索算法显存消耗过大,并且在复杂搜索空间中对时延优化十分困难。针对上述问题,本文分别从模型和结构两方面对神经网络进行优化。其中,模型优化是指对模型参数的优化,结构优化是指网络结构中操作和连接的优化。对现有模型参数,论文提出基于李普希兹约束的迭代式量化算法和可训练低秩分解;除了优化现有模型,论文还设计新的NAS算法来探索更高效的网络结构:提出部分连接的可微网络结构搜索,解决了目前可微NAS搜索显存消耗过大的问题;进一步设计了约束超网络的优化的时延损失,从而搜索硬件友好的网络结构。